共计 1022 个字符,预计需要花费 3 分钟才能阅读完成。

1. 确认模型支持情况

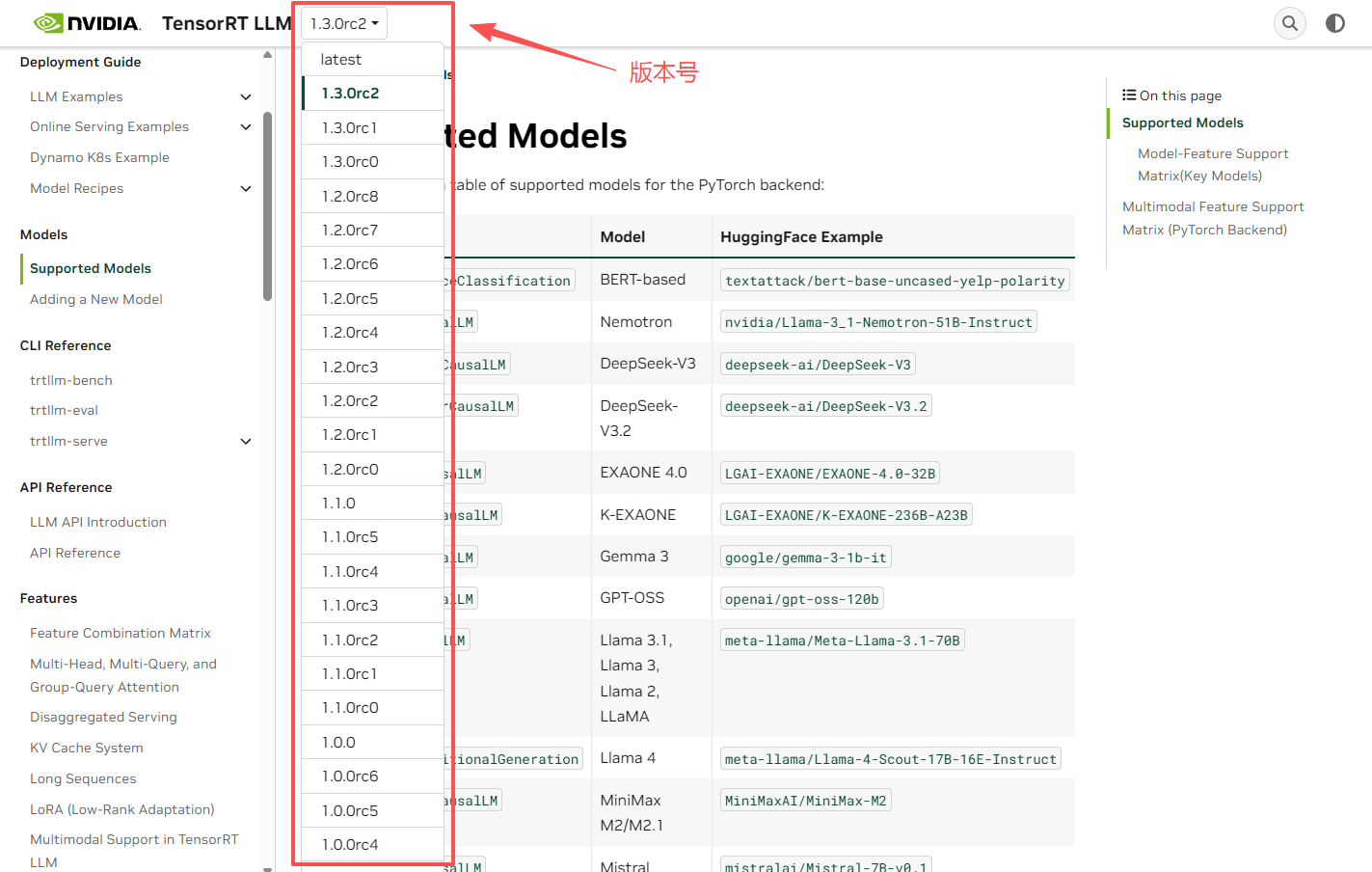

在用 tensorrt-llm 部署大模型服务之前,需要先确认,想要部署的模型是否被支持

请访问官方的文档:https://nvidia.github.io/TensorRT-LLM/latest/models/supported-models.html

该网页中会列出某版本下支持的大模型和多模态大模型。请着重注意版本号,如下图中 1.1.0 为正式版本,1.3.0rc2为预发版本。各个版本之间支持的模型可能有所不同(一般情况下,版本号越大,支持的模型越多)

2. 下载镜像

(极力推荐使用镜像的方式来部署)

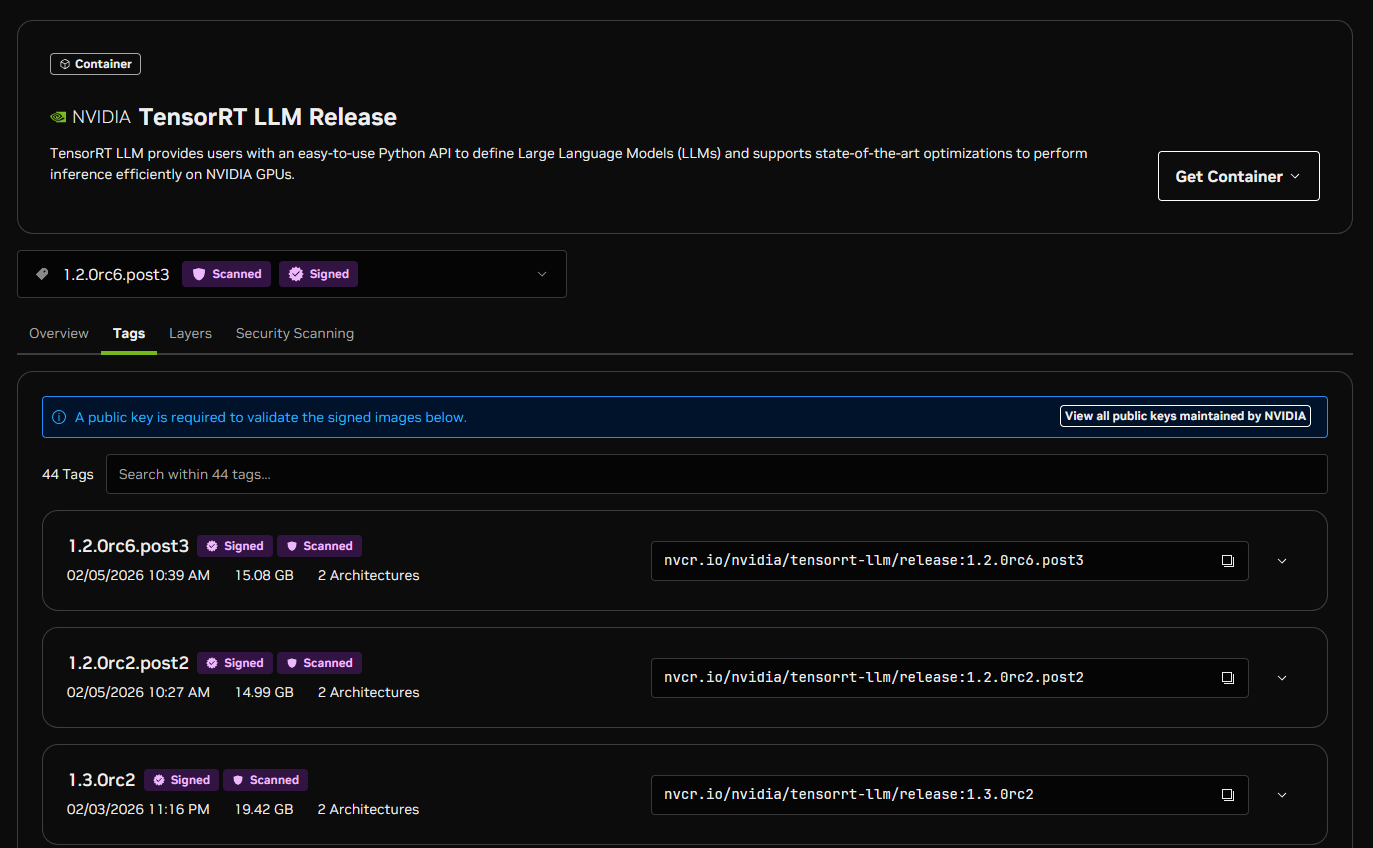

针对第一步确认好的版本,请访问官方的镜像仓库来获取具体版本的镜像地址:https://catalog.ngc.nvidia.com/orgs/nvidia/teams/tensorrt-llm/containers/release/tags

以 1.3.0rc2 版本为例,下载命令为:

docker pull nvcr.io/nvidia/tensorrt-llm/release:1.3.0rc23. 启动容器

启动命令示例

docker run --rm -it --ipc host \

--gpus '"device=0"' \ # 使用 0 号显卡

--ulimit memlock=-1 \

--ulimit stack=67108864 \

-p 0.0.0.0:8000:8000 \ # 透出 8000 端口

-v ./Qwen3-VL-8B-Instruct:/Qwen3-VL-8B-Instruct \ # 挂载模型文件目录

-v ./data:/data \ # 附加挂载目录(该处可存放 config.yml 文件)\

nvcr.io/nvidia/tensorrt-llm/release:1.3.0rc2

启动后,会自动进入容器内的 bash

4. 启动服务

4.1 默认启动

启动命令:

trtllm-serve < 模型目录 > --config <config 文件路径 > --host 0.0.0.0 --port 8000示例:

trtllm-serve /Qwen3-VL-8B-Instruct --config /data/config.yml --host 0.0.0.0 --port 80004.2 其他参数

--free_gpu_memory_fraction 0.7:显存占用 70%--max_num_tokens 40000:最大传入 tokens 40000(默认值为 8k)--max_batch_size 4:限制 batch 数

正文完

发表至: 人工智能

近一天内